机器能模拟人类感受?明略科技多模态团队斩获ACMMM全球顶会“最佳论文提名”

2024-11-07

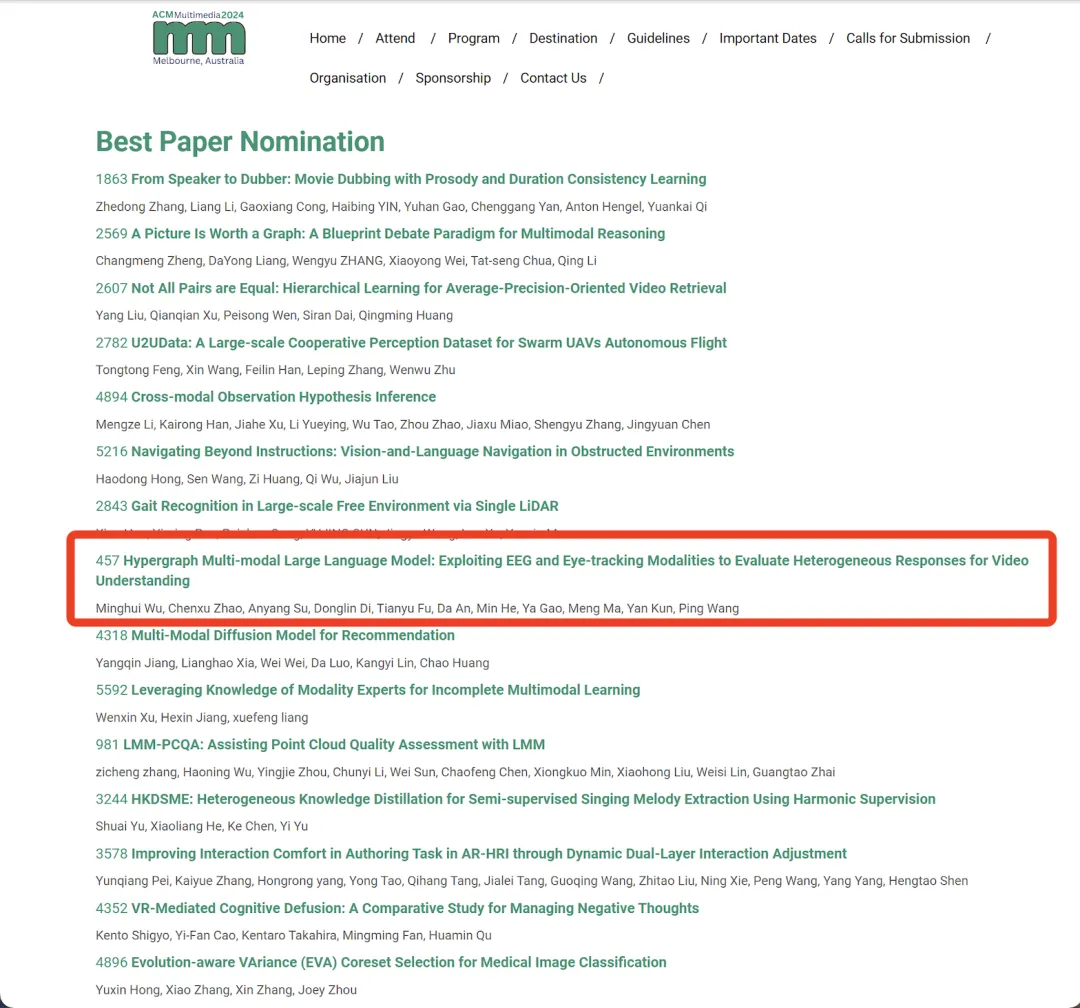

10月28日~11月1日,全球顶级多媒体会议ACM Multimedia(ACMMM)2024 在澳大利亚墨尔本成功召开。明略科技集团多模态团队与北京大学共同完成的最新研究成果《Hypergraph Multi-modal Large Language Model: Exploiting EEG and Eye-tracking Modalities to Evaluate Heterogeneous Responses for Video Understanding》在众多论文中脱颖而出,荣获最佳论文提名(Best paper nomination)。明略科技集团创始人、董事长兼CEO吴明辉,多模态大模型部门负责人赵晨旭,明敬算法负责人苏安炀受邀赴墨尔本出席此次会议。

据悉,本次会议共收到4385篇有效投稿,其中,1149篇论文被接收,174篇论文被评选为Oral,最终仅26篇获得最佳论文提名。

ACMMM会议是由国际计算机学会(ACM)主办的多媒体领域的顶级国际学术会议,同时也是中国计算机学会推荐的A类国际学术会议(CCF-A)。自1993年举办以来,今年是第32届。会议议题涵盖多媒体计算的各个方面,如多媒体内容分析、多媒体检索、多媒体安全、人机交互、计算机视觉等。

针对当前AI领域在视频内容理解方面主要聚焦于客观层面,缺少主观层面的测量标准,以及机器模拟人类主观感受的有效手段的发展情况,明略科技的最新研究成果整合脑电、眼动信号等多种非标模态,构建了全新的多模态大语言模型范式,在机器理解和模拟人类主观感受的研究方向,迈出了重要一步。

论文题目:Hypergraph Multi-modal Large Language Model: Exploiting EEG and Eye-tracking Modalities to Evaluate Heterogeneous Responses for Video Understanding(超图多模态大语言模型:应用脑电和眼动模态来评估异质人群观看视频时的响应)

作者:吴明辉*,赵晨旭*,苏安炀*,狄东林,傅天宇,安达,何敏,高雅,马萌,颜鲲,王平(*为共同第一作者)

论文摘要:对视频创意和内容的理解往往因人而异,不同年龄、职业和性别的人的关注点和认知水平也存在差异。目前缺乏这方面的研究,没有可以进行评测的基础,大多数现有的基准都存在几个缺点:

1)模态数量有限,题目多为选择题,难以测量逻辑推理过程;

2)视频中的内容和场景过于单调,仅涉及到对视频内容的客观描述。

为了弥合与实际应用的差距,明略科技引入大规模的视频主观多模态评估数据集Video-SME。通过收集不同人群在观看相同视频内容时脑电图 (EEG) 和眼动追踪区域的真实变化,设立了新的任务和协议,分析和评估不同受试者对相同视频内容的认知理解程度。

依托新的评测标准,明略科技创新研发了超图多模态大语言模型 (HMLLM),探索不同人口统计、视频元素、脑电图和眼动追踪指标之间的关联。HMLLM可以弥合丰富模态之间的语义差距,并集成帧与帧之间的信息以执行逻辑推理。明略科技在Video-SME和其他基于视频的生成性能基准上设计了实验,大量实验评估证明了该方法的有效性。

人在观看广告视频时,对于素材元素的认知程度、情绪高低、眼睛注视程度高低都是人的主观感受,不同性别、年龄、职业、身份的人群都会有所不同。

如果机器能够模拟不同人群观看广告视频时的不同主观感受,那么相当于可以对广告视频的内容、创意等进行有效的测量,指导广告成片过程,节省广告投放成本。

下述视频展示了论文中的方法(HMLLM)对于经典广告成片的解析,从主观和客观两个维度进行分析:

下述视频展示了论文中方法(HMLLM)对于同一段广告视频,通用人群和特定人群不同的主观反应:

让机器学习、理解和模拟人类的主观感受,可能是赋予机器主观意识的开端。明略科技提出的新基准Video-SME有望成为该领域的新起点,标志着机器对视频的理解从客观维度向主观维度的转变。作为一种全新的范式,明略科技多模态大模型HMLLM的研发,致力于为该领域研究人员解决非标准模态问题提供宝贵经验与启示,从而促进大模型领域向人机协同的美好未来迈进。

本研究课题由科技部科技创新2030——“新一代人工智能(2030)”重大项目支持。

信息填写