从算法模型发展,看生成式AI在视觉领域的发展与应用

2023-06-01

这一新型的AI被称为“生成式人工智能”(Generative AI),也就是说,机器并非如之前那样仅分析已有的数据,而是生成了全新的东西。

——《生成式AI:充满创造力的新世界》

我们正在进行的工作和生活,都在因为生成式AI的发展而变化,尤其是在创意这个领域。营销行业,是创意的聚集地,也正是生成式AI“大显身手”的地方。无论是文本内容、图像视觉,还是视频创意,生成式AI正在营销工作的方方面面帮助我们寻找“新玩儿法”。

这其中,最吸引眼球的领域莫过于图像与视觉创意的领域。红杉资本预计,2025年,生成式AI已经可以给我们提供最终版本的产品和建筑设计图了。这一切似乎发生的如此迅速,让我们有些“猝不及防”。但其实早在2012年,一切就已经开始了。我们认为,这背后的驱动里就是技术模型的不断迭代。

今天,我们就来梳理一下生成式AI在视觉领域一路走来的发展和应用吧。

纵观整个生成式AI的发展,可以说,深度学习技术的升级迭代、算法模型的发展,为计算机视觉发展奠定基础。每一次算法模型的迭代,都会带来一波计算机视觉领域的大发展,按照时间线,我们来了解下那些耳熟能详的模型如何影响视觉领域发展。

01 旗开得胜:卷积神经网络CNN

算法介绍

卷积神经网络CNN的出现,是计算机视觉的一个分水岭。在2012年之前,计算机视觉还是基于“手工算子”的传统视觉时期。而卷积神经网络,也就是CNN的出现,在图像分类任务上远超传统算法,可谓一战成名,开启了深度学习的一个时代。

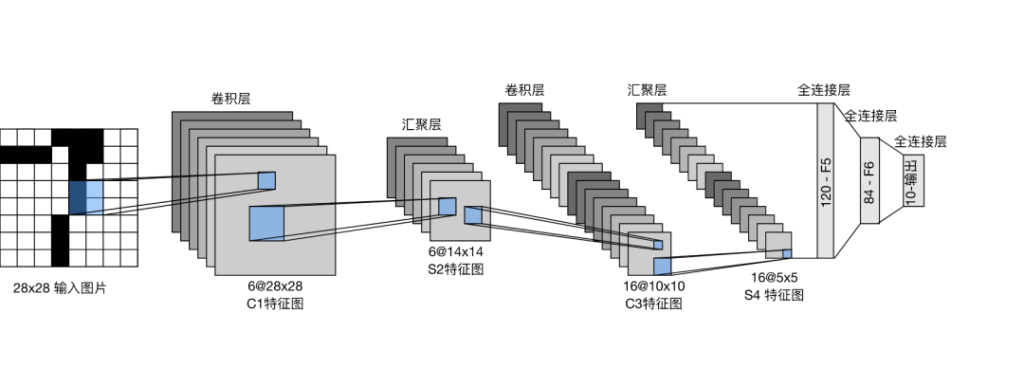

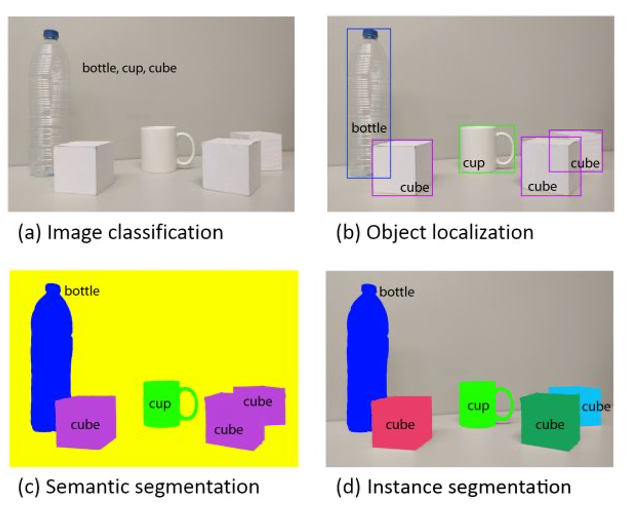

作为一种深度学习模型,CNN广泛应用于如图像分类、目标检测、语义分割等视觉任务。它一般由多个卷积层、池化层或全局平均层等组成。卷积层可以自动提取输入图像中的特征,而池化层则可以将卷积层中的特征进行简化和压缩,以便更好地进行后续处理。最后,全局平均层将前面所有层的结果进行加权并进行投票,以确定输出。在深度学习的发展中,研究者们还提出更多适用于不同任务的网络层,从而组成复杂且庞大的网络结构,助力神经网络的蓬勃发展。

算法应用

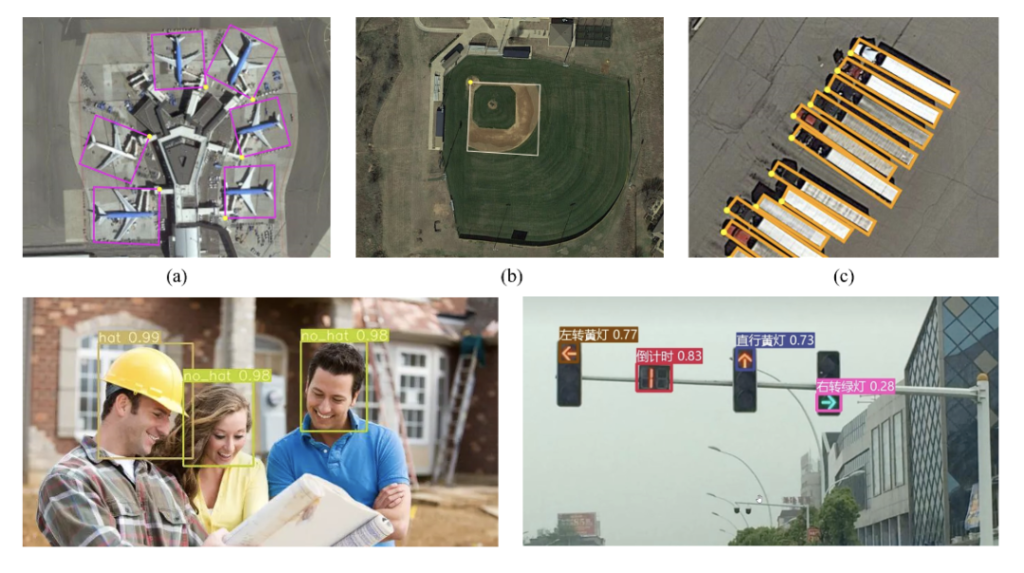

CNN算法迅速引起了当时业内的关注。在2012年,基于这个算法,诞生了图像识别的诸多应用,如人脸识别、物体识别、图像分类等。像我们熟悉的AI四小龙也是在这个时间段诞生。

在行业的共同推进下,图像识别技术迅速在包括支付、营销、安防、自动驾驶、工业质检、智慧城市等领域迅速发展,很多领域开始深入应用图像识别技术,如今这个技术已经深入到了我们的工作和生活中。

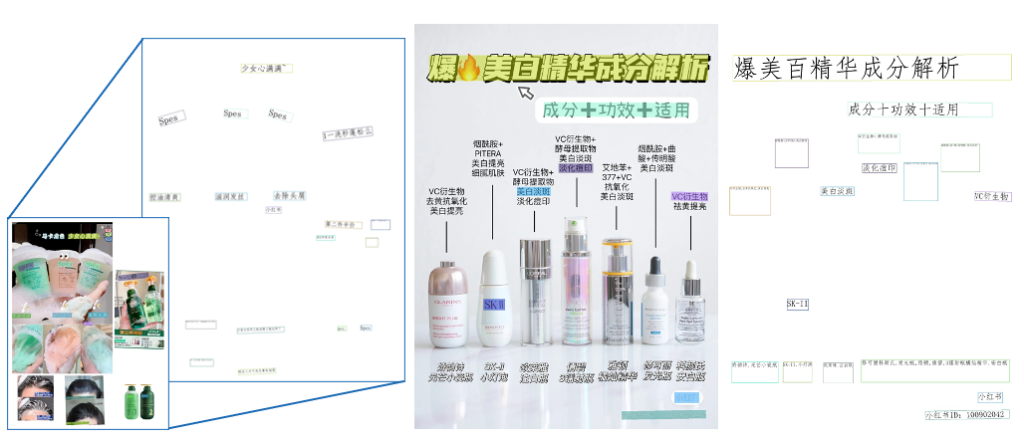

在营销领域,分析用户喜好可以更加直观,除了文字识别,还可以加入对于评测的图像识别,让品牌对于社媒评测的理解更加立体。

02 乘风破浪:生成式对抗网络GAN

算法介绍

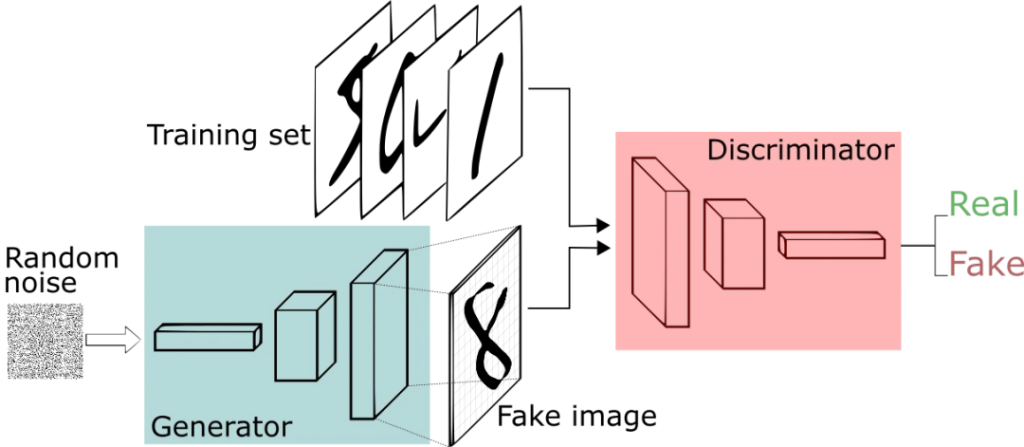

时间来到2014年10月,“GAN之父”Ian Goodfellow提出了生成式对抗网络,广泛使用于图像生成、数据增强和文本生成等任务。顾名思义,这个深度学习模型由两个神经网络组成,分别是生成器和判别器,并让他们相互“对抗”。生成器用于生成新的样本,而判别器则用于判断生成器生成的样本是否真实。两个模型互相博弈,在虚拟与求真的对抗中,逐步训练并生成一个更佳的内容。

GAN的算法模型可谓“家族庞大”,在2014年之后,沿着这种“对抗”的思路,生成对抗模型也一直在发展,包括Pix2Pix、SRGAN、Cycle-GAN、BigGAN、StyleGAN……等。

算法应用

伴随着GAN模型体系的发展,图片的生成也从图片到图片的风格迁移,发展到了文本指导的图片生成,可以实现图片风格、人脸特征、物体细节的转变。

这个阶段,我们能够看到的营销玩法就更加多样化了,在图片美化、视频拍摄和剪辑、视频特效、视频会议等等方面,都有了很多使用场景。

03 继往开来:Vision Transfomer模型

算法介绍

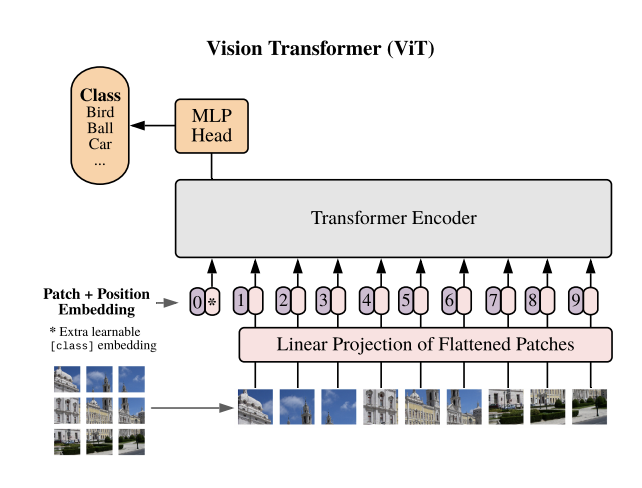

2020年,Vision Transformers模型(ViT模型)把NLP领域霸榜的模型引入了视觉领域。相比传统的卷积神经网络(CNN)模型,Vision Transformers将图像划分为多个小块(patches),并引入自注意力机制,通过学习更大规模的数据集,实现了规模和计算精度的一个跨越式的提升。

算法应用

一方面,ViT模型可以在很多领域实现显著的精度提升,包括图像分类、目标检测、对象检索、语义分割、图像生成和视频摘要等多个领域。

另一方面,ViT模型将视觉能力引入到自然语言理解模型范式中,显著降低了不同模态(如视觉和文本)信息的交互成本,充分激发了多模态领域的蓬勃发展,这也为后续的大模型做了充分的准备。

04 精益求精:扩散模型Diffusion

算法介绍

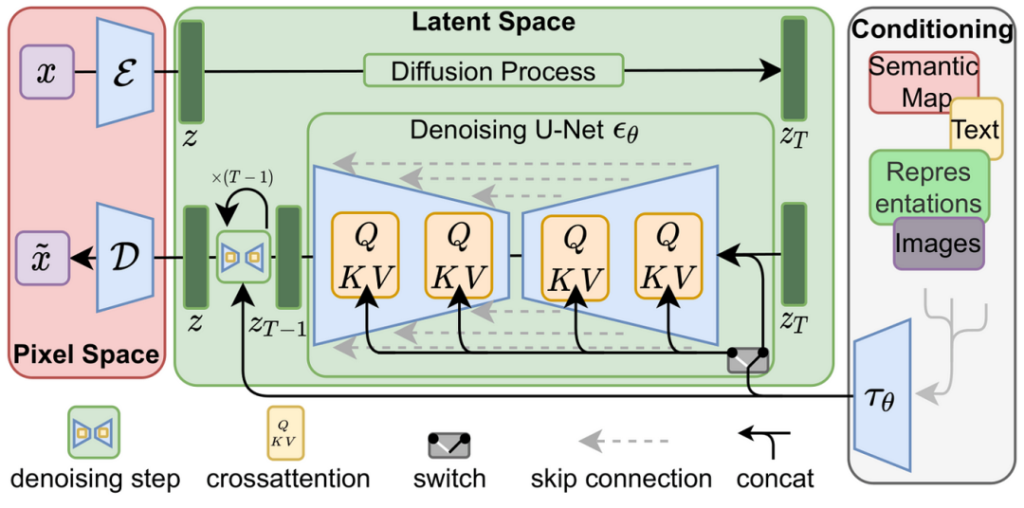

之所以我们看到Midjourney等生成式AI系统在画图领域这么火,主要是因为2022年,Diffusion模型的“进化“。

作为一种机器学习技术,Generative Diffusion Models(生成式扩散模型)具有强大的生成能力。它们能够根据给定的初始值和一些参数,在训练过程中逐步演化生成新的数据样本。其核心思想是通过迭代的扩散过程来生成数据:从一个初始值开始,并通过多个迭代步骤逐渐“扩散”数据。每个迭代步骤都会降低这些随机噪声,并根据模型的参数和其他约束条件(如文本、图片等)进行数据更新。随着迭代的进行,数据逐渐演化,生成出与训练数据类似的新样本。通过使用Generative Diffusion Models,我们可以生成逼真的图像、音频、文本等多种类型的数据。

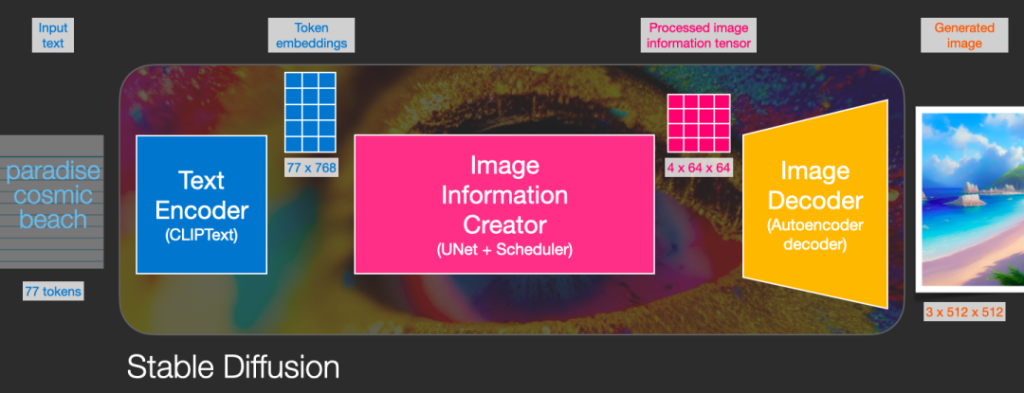

在2022年7月,创业公司提出Stable Diffusion并开源使用,进一步推进了AIGC在视觉任务的发展。该算法使用了感知压缩(Perceptual Compression)的技巧,将图像从像素空间映射到潜在空间,然后在潜在空间上进行扩散操作,最后再解码回像素空间。它还引入了条件机制(Conditioning Mechanisms),通过交叉注意力(Cross-Attention)的方式来实现多模态训练,使得条件图片生成任务也可以实现。这一模型大幅降低了训练成本,提升了收敛速度与训练稳定性,一经发布迅速地成为了AIGC中的基线模型,研究者和创业者们基于这一算法思想,孕育了更多的算法与应用创新。

算法应用

通过Diffusion Models, 我们看到了更多视觉生成的可能性,除了文图生成,还有类似风景图语义合成、布局图片生成、图片修复、图片扩展等等。在语义和图像的结合上,机器能做到更深入的理解和输出了。

这一部分在营销应用上有巨大潜力。例如,利用LORA技术,我们可以使用17张不同角度的车辆图片训练模型,并根据需求将训练的车型与任意背景进行融合。这样,我们可以在3-5分钟内生成出右侧展示的图片,该车型能够完美融入欧式街道背景,实现出色效果。

其实,我们可以看到很多人开始探索这项技术在多种任务上的应用,比如漫画插图、AI技术模特、室内设计出渲染方案。可以说,我们已经在方方面面感受到了生成式AI在视觉与营销的结合上可以有非常多的想象空间。

05 未来已来:多模态模型正在发展

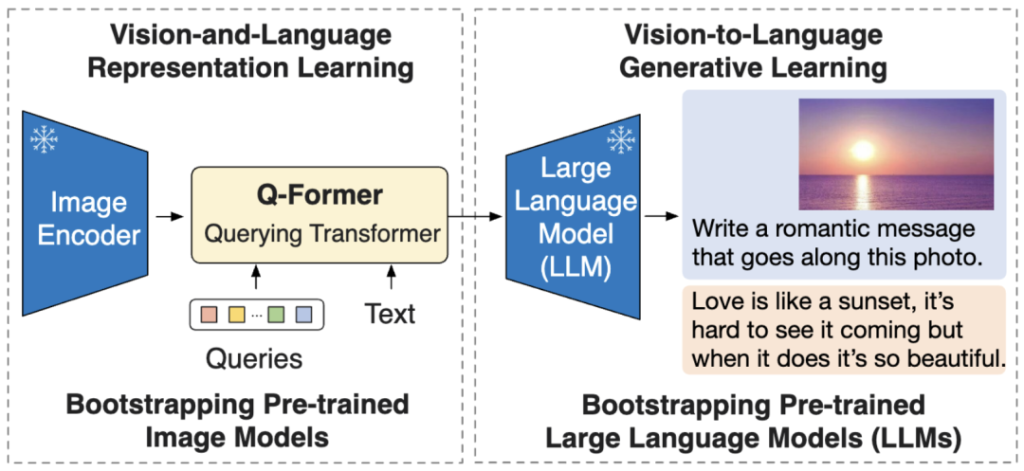

大型模型的迭代速度非常快,最近我们观察到热门的研究方向还集中在多模态训练上。在ChatGPT大火的今天,大语言模型已经被人们所熟知,但既包括自然语言输入、又包括图像输入的网络结构,也引起了研究者们的关注。在下图中,图片编码器处理输入图像,提取其高维特征,并通过Q-Former这样一个Transformer结构,架设了视觉与大型语言模型的桥梁。

举个例子,我们输入一张图片,并要求网络根据该图像描述一段浪漫的文字,输出结果可能是”爱就像落日,虽然它很难被察觉,但一旦出现,它是如此美丽”。这样的句子即清晰地描述了图片的内容,又延伸出了一种浪漫的感觉。这种融合了图像和语言信息的模型似乎真的能让我们感受到机器的浪漫。在营销智能里,我们期盼这样的多模态大模型能给业务带来更多有想象力的应用。

未来我们面临的是新范式下的新时代,相信,也是创意与营销生产力爆发的时代。随着机器告诉我们浪漫的落日与爱,我们似乎可以真的可以和“机器模型”一起,去探索消费者的心智,分析真正的消费趋势和需求热点。而通过生成式AI的赋能,我们也可以更好的提供个性化的用户体验,让营销人从重复劳动中解放出来,和AI共同探讨创意本身。期待AI和我们并肩,实现真正的人机同行。

信息填写